ControlNet es un modelo de Stable Difussion que ofrece la posibilidad de tener un control sin precedentes sobre la composición y la postura de las imágenes generadas.

Los usuarios de Stable Diffusion están familiarizados con la complejidad que supone generar la composición exacta que se busca.

Las imágenes tienden a ser bastante aleatorias y la única estrategia disponible hasta ahora era la de generar muchas imágenes hasta llegar a una similar a los deseado.

Sin embargo, con ControlNet, los usuarios tienen por fin la capacidad de controlar con precisión la ubicación de los sujetos y su apariencia.

Lo mejor es que es Open Source, por lo que puedes probarlo gratis en Hugging Face, montar un Colab o incluso instalarlo en tu PC si tienes una máquina suficientemente potente.

En este artículo, te proporcionamos toda información necesaria acerca de ControlNet, sus posibilidades y cómo puedes ponerlo a trabajar para ti.

¿Qué es ControlNet?

ControlNet es un modelo de red neuronal diseñado para controlar modelos de Stable Difussion mediante la adición de nuevos condicionantes.

El uso más elemental de los modelos de Stable Difussion es la conversión de texto a imagen, pero ahora es posible añadir nuevas instrucciones para guiar el proceso.

Por ejemplo es posible añadir garabatos y que el modelo los replique en imágenes hiperrealistas o capturar la pose de una figura humana para ponerla en diversas situaciones.

Esta combinación permite a los usuarios tener un control sin precedentes sobre la composición y la postura de las imágenes generadas.

En otras palabras, en lugar de depender de la aleatoriedad, ahora es posible influir en el resultado final mediante la introducción de información adicional en el modelo.

Los múltiples usos de ControlNet y sus modelos

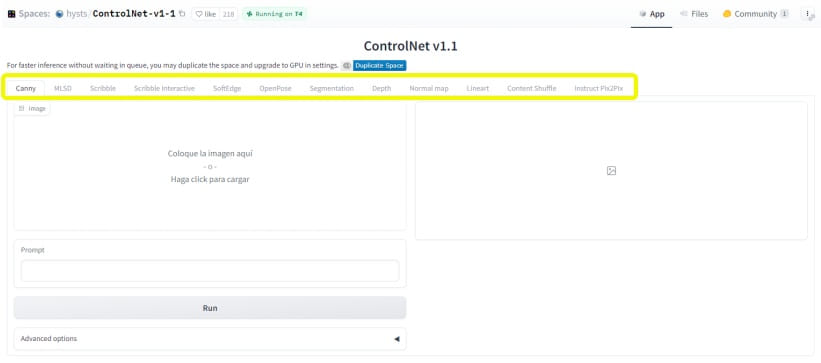

ControlNet se divide a su vez en diversos modelos, cada uno de los cuales está especializado en algún tipo de modificación o recreación concreta de las imágenes.

Al tratarse de una tecnología en constante desarrollo los modelos cambian continuamente y es posible que no los abarque todos, pero intentaré explicar aquí los más usados:

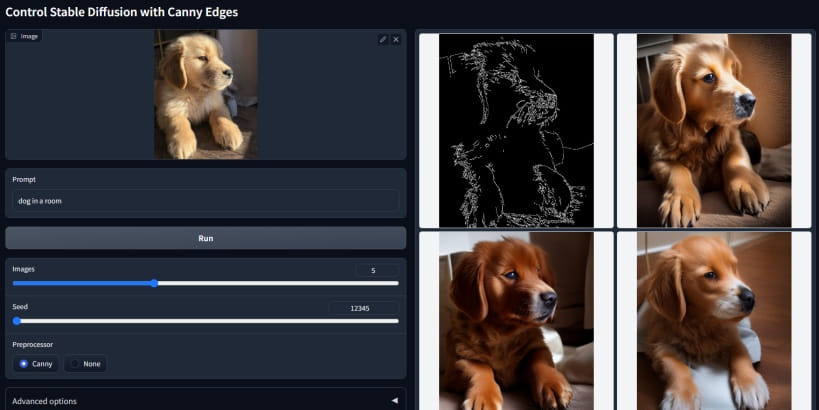

Modelo Canny Edge de ControlNet

El modelo Canny Edge de ControlNet se centra en mantener la postura del sujeto constante, mientras que los elementos como el entorno, el clima, el color y la hora pueden variar.

Este modelo es ideal para situaciones en las que se desea mantener la consistencia de la postura del sujeto, pero se desea experimentar con diferentes entornos y condiciones.

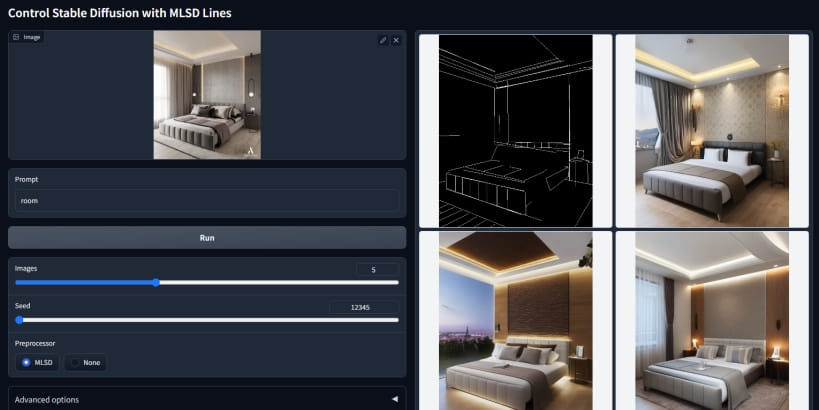

Modelo MLSD

El modelo MLSD de ControlNet utiliza la detección de líneas rectas M-LSD para crear imágenes más precisas.

Este modelo es útil cuando se desea enfocar en la estructura lineal de la imagen, como es el caso de los edificios y otras estructuras arquitectónicas.

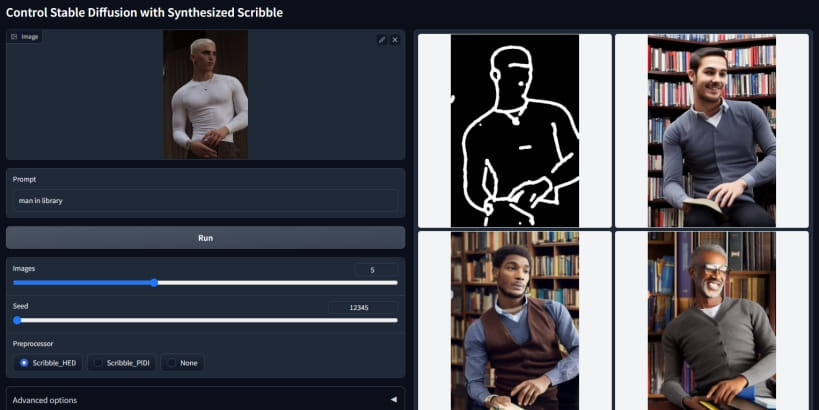

Modelo Scribble

El modelo Scribble requiere que el usuario dibuje un garabato de un objeto y lo suba como imagen de entrada para obtener imágenes de salida impresionantes.

Este modelo es perfecto para situaciones en las que se desea tener un control creativo sobre la imagen final.

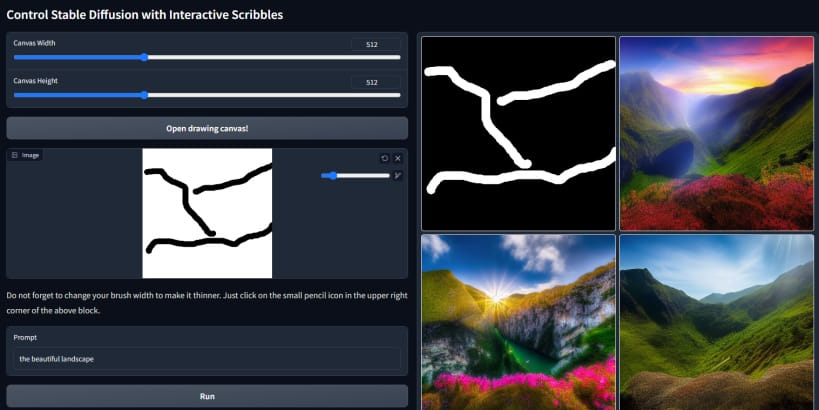

Modelo Interactive Scribble

El modelo Interactive Scribble permite al usuario dibujar su propia creación directamente en la aplicación y ponerla como imagen de entrada.

Este modelo ofrece un alto nivel de interactividad y control creativo al usuario. Ideal para cuando se requiere una solución rápida.

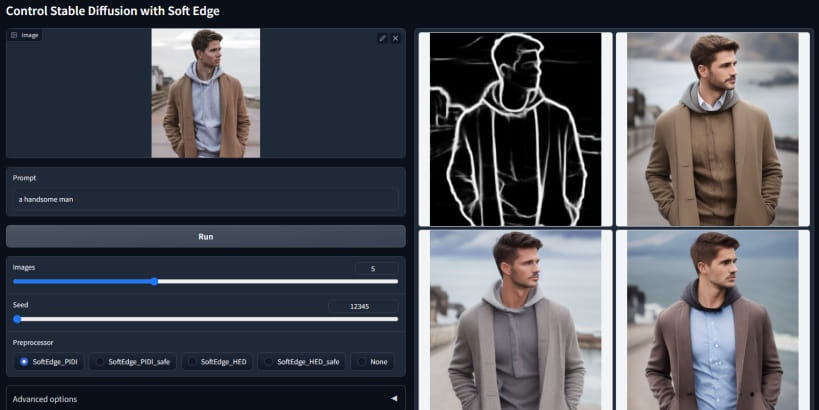

Modelo SoftEdge

El modelo SoftEdge conserva muchos detalles en las imágenes de entrada para crear imágenes asombrosas.

Este modelo es ideal para situaciones en las que se desea mantener la mayor cantidad de detalles posible en la imagen final.

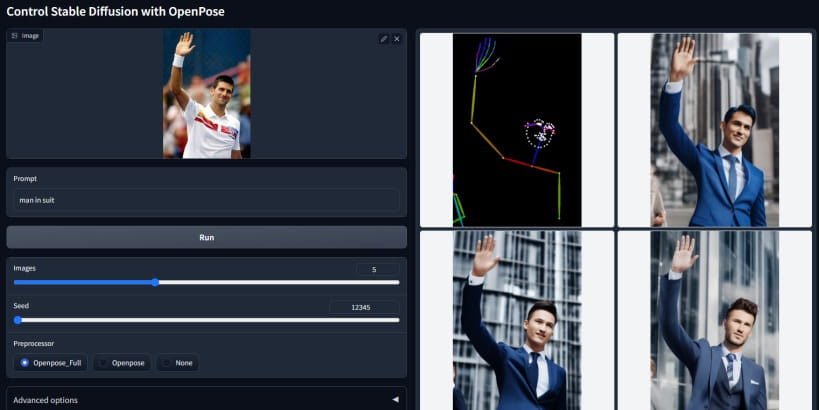

Modelo Open Pose

El modelo Open Pose o Human Pose capta únicamente el esqueleto de la imagen que le proporcionas.

Esto es útil cuando deseas enfocarte solo en la postura humana para que el sujeto de la imagen final se muestre en la misma posición.

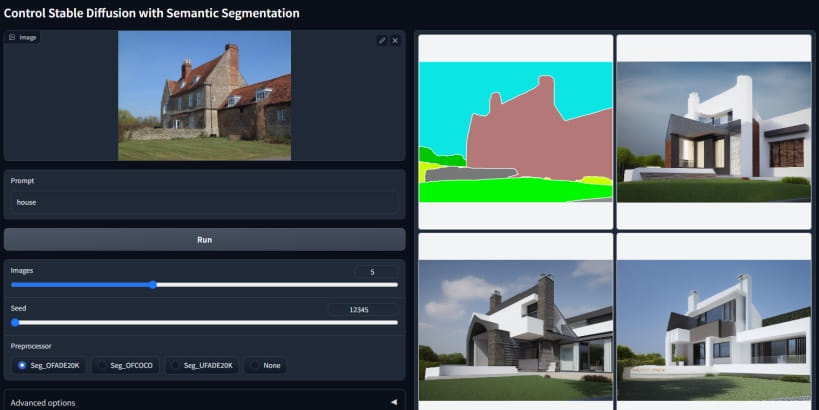

Modelo Segmentation

El modelo Segmentation permite al usuario dibujar directamente las segmentaciones.

Es ideal para situaciones en las que se desea tener un control detallado sobre las diferentes segmentaciones en la imagen final.

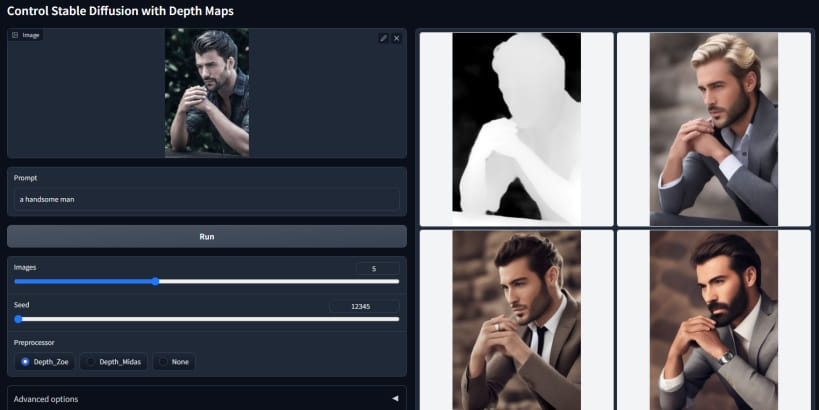

Modelo Depth

El modelo Depth recibe un mapa de profundidad completo, lo que significa que conservarás más detalles en el mapa de profundidad.

Este modelo es útil cuando se desea tener un control detallado sobre la profundidad en la imagen final.

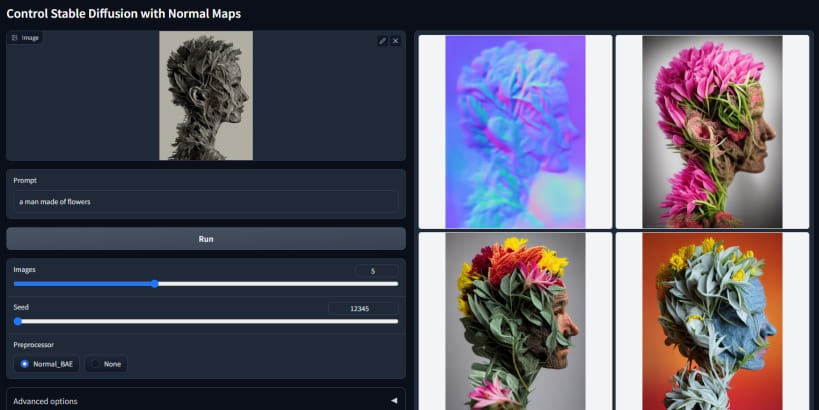

Modelo Normal Map

El modelo Normal Map utiliza un mapa normal para determinar cuántas áreas están en el fondo con una normal identidad al espectador.

Es bueno para situaciones en las que se desea tener un control detallado sobre las áreas de fondo en la imagen final.

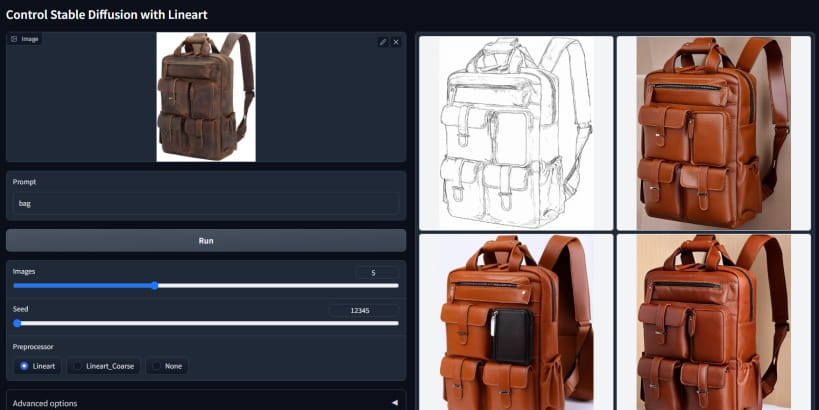

Modelo Lineart

Se usa para generar imágenes lineales detalladas basándose en otras imágenes del mismo estilo lineal.

Este modelo está entrenado con una importante cantidad de datos de este tipo y acepta incluso dibujos lineales dibujados a mano.

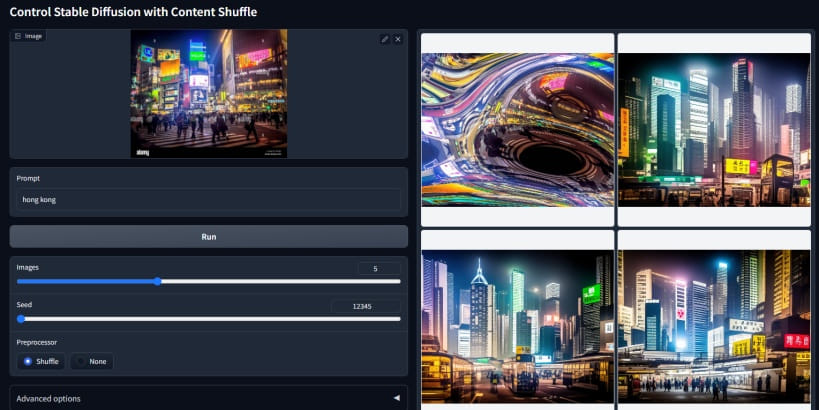

Modelo Content Shuffle

El modelo Content Shuffle está entrenado para reorganizar imágenes de modo aleatorio.

De este modo puedes obtener resultados visualmente similares en composición y colores pero que no tienen nada que ver con la imagen original.

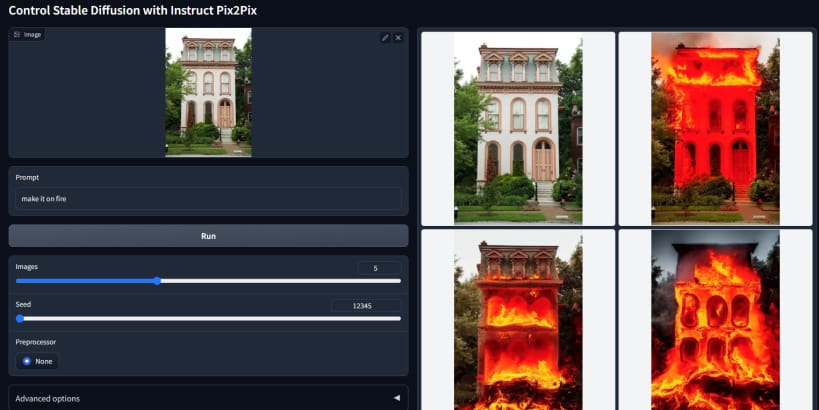

Modelo Instruct Pix2Pix

No confundir con el modelo Pix2Pix de Stable Difussion oficial. En este caso se ha entrenado con un 50% de indicaciones tipo instrucción y un 50% de indicaciones tipo descripción.

Esto quiere decir que puede funcionar tanto para pintar imágenes tipo “un coche rojo” (descripción) como “haz que este coche sea rojo” (instrucción).

Como puedes ver hay múltiples modelos disponibles y muchos más que siguen apareciendo o se actualizan para afinar más las imágenes.

Para estar al día con todas las novedades puedes visitar el github de la última versión del proyecto aquí:

https://github.com/lllyasviel/ControlNet-v1-1-nightly

ControlNet v1.1 ¿Cómo empezar?

Si quieres comenzar a usar ya la última versión ControlNet tienes varias alternativas dependiendo de tu nivel de conocimientos. Aquí te expongo cada una de ellas:

Usar Hugging Face (nivel principiante)

La plataforma tiene un generador online gratuito que no requiere de ningún tipo de configuración. Simplemente entrar y comenzar a generar imágenes.

El problema es que al ser gratis hay que hacer cola antes de procesar una imagen y falla bastante. Las opciones de personalización también son más limitadas.

Es bueno para hacer pruebas rápidas y ver como funcionan los modelos pero no sirve para un uso extensivo de generación de imágenes.

Puedes acceder desde aquí: https://huggingface.co/spaces/hysts/ControlNet-v1-1

ControlNet en Google Colab (nivel intermedio)

Google Colab es un servicio de procesamiento informático en la nube propiedad de Google con el que puedes ejecutar todo tipo de aplicaciones, incluido Stable Difussion con ControlNet.

Hay decenas de colabs ya creados para que solo tengas que clonarlos a tu Drive de Google y ejecutarlos paso a paso con instrucciones claras.

El problema es que ante el aumento de la demanda, Google ha bloqueado el uso de Stable Difussion en las cuentas gratuitas, de modo que ahora se requiere una cuenta de pago (unos 10 $/mes) para poder usarlo.

Si no tienes un ordenador potente y quieres hacer un uso algo más intensivo del modelo esta es la alternativa más apropiada.

Aquí dejo uno de los colab más usados: fast_stable_diffusion_AUTOMATIC1111.ipynb

En este vídeo, el divulgador de IA Dot CSV explica bien como ponerlo en funcionamiento (minuto 12:39 aprox).

Instalar ControlNet en tu PC o Mac (nivel experto)

Por último si tienes un PC o Mac con un hardware lo suficientemente potente puedes descargar el modelo y usarlo en local gratis y sin ningún tipo de limitación.

Los requerimientos mínimos se encuentran en poseer una GPU con al menos 4gb de VRAM, pero debe ser una gráfica dedicada de NVIDIA. Una GPU integrada tipo AMD no funcionará.

Si cumples con los requisitos antes de nada tendrás que instalar Stable Difussion en tu PC para posteriormente añadirle los modelos de ControlNet.

El método más extendido es usar la interfaz web de AUTOMATIC1111, la cual está respaldada por una gran comunidad y se actualiza con frecuencia.

No voy a entrar en más detalles pero sí que voy a compartir los tutoriales que yo usé:

- Este para instalar Stable Difussion en Windows: https://stable-diffusion-art.com/install-windows/

- Y este otro para añadir los módulos de ControlNet v1.1: https://stable-diffusion-art.com/controlnet/

Ambos son bastante sencillos de seguir y están explicados paso a paso aunque están en inglés, pero para eso tenemos el Traductor de Google.

Relacionados

-

Samsung tiene una alternativa a ChatGPT en desarrollo

-

Luma AI: la IA que convierte imágenes en modelos 3D

-

ImageFX: el nuevo generador de imágenes con IA de Google

-

¿Cómo puedo saber si una descarga es segura?

-

Las 15 mejores extensiones para ChatGPT en Chrome

-

Midjourney v5.2 ya está listo, descubre sus nuevas funciones